TensorStack AI 计算平台

新一代 AI 集群基础设施软件,助力计算智能化

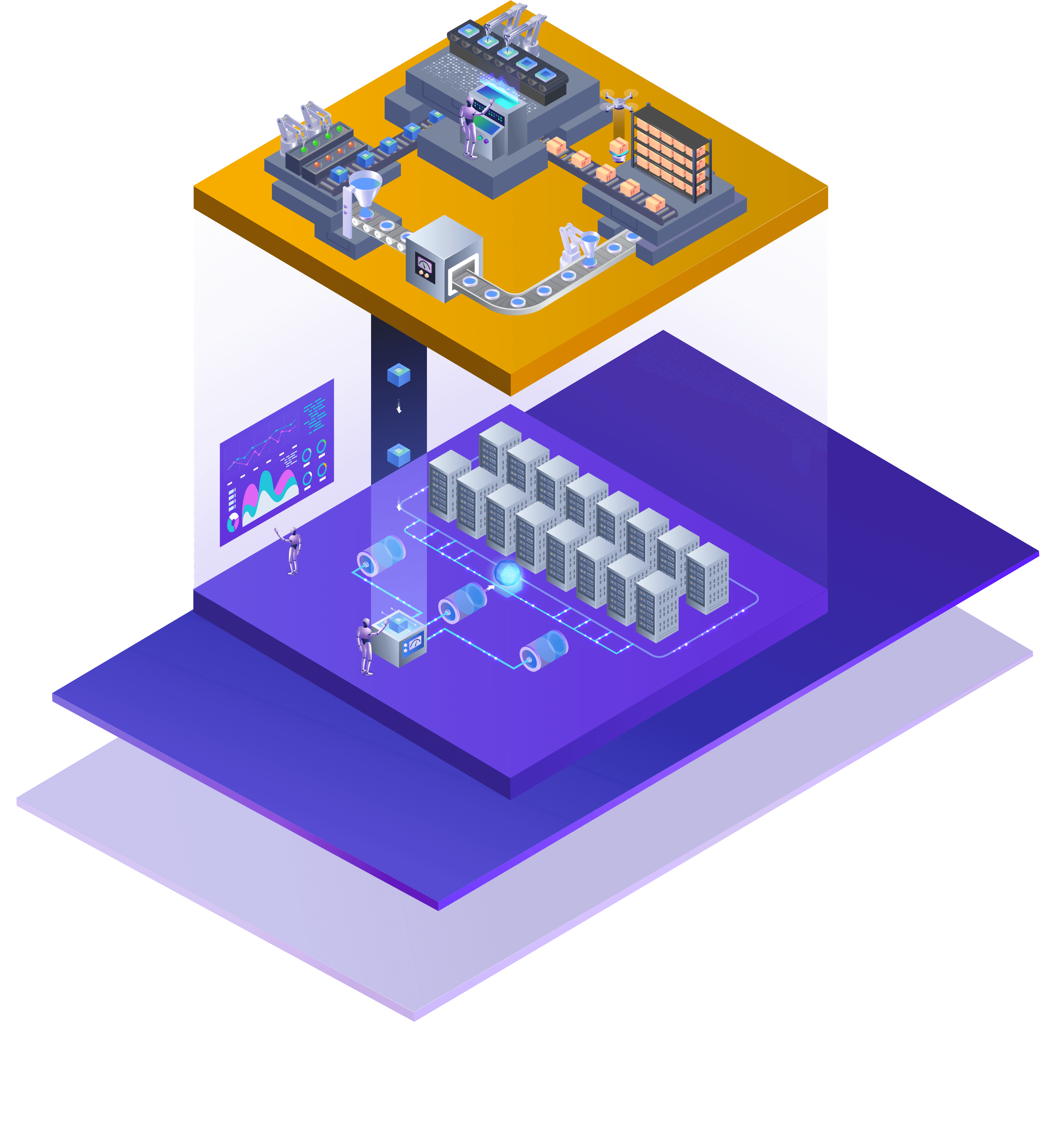

“TensorStack AI 计算平台” 支持用户方便地在 AI 集群上进行规模化研究、开发、部署和运维 AI 技术;并提供对集群算力、安全、数据等全面的管理能力。

AI 全流程开发支持,涵盖数据准备、模型开发、模型训练和调优、实验管理、模型部署、自动化工作流等功能;并且能够方便地集成第三方工具和服务。

数据准备

模型开发

模型训练

实验管理

模型管理

模型部署

高度可扩展的架构,支持海量(P+)数据集管理;提供先进的类 git 形式的数据集版本控制功能,实现对数据集的灵活生命周期管理,方便实施各种数据集的发布策略;并提供安全访问控制、大文件上传下载、S3 协议等特性。

在线开发环境 Notebook(JupyterLab + TensorStack 扩展)支持 AI 的全流程开发和部署,并能够快速将 Notebook 转换为工作流服务的任务节点,实现计算任务的组合执行。支持本地 VS Code 等通过 SSH 远程连接到平台进行开发。

全面支持 AI 计算的数据驱动、迭代式开发过程,提供实验管理服务,包含实验追踪、实验数据存储、实验数据可视化分析和实验对比等功能,可靠地追踪 AI 模型生产过程,集中管理访问控制,实现可追溯的实验历史记录,满足系统化管理和分析实验数据的需求。

支持 TensorFlow、PyTorch、XGBoost 等机器学习框架,Horovod, DeepSpeed,Colossal-AI 等大规模分布式并行训练框架,及 MPI 高性能并行计算框架; 支持故障节点自动隔离、计算任务迁移等容错手段,以自动恢复失败计算任务,保障高价值大型计算任务长期可靠运行;支持弹性规模扩展等自动化计算机制。

自动化机器学习工具 AutoTune 致力于自动化 AI 模型的构建,在降低 AI 应用的开发门槛和人力成本的同时实现最佳性能;融合最佳实践,提高企业 AI 生产效率。

代码包 (Codepack)系统提供一体化管理 AI 项目能力,实现精确复刻、快速迭代、团队协作等功能。

分布式计算、灵活的工作流系统、智能调度及集群资源管理等支撑技术,显著提高用户在复杂异构环境下的计算性能和效率,提升 AI 投资回报率。

“TensorStack Workflow” 系统能够把复杂的计算步骤灵活地组合在一起,进行统一管理和调度,在集群中实现复杂大规模计算工作流自动化。

“TensorStack Scheduler” 专为 AI 计算集群设计,提供运行大规模工作负载所需的高级调度功能,包括任务队列、配额、优先级、自动抢占/恢复、协同调度、拓扑结构感知等,便于用户充分使用集群计算资源进行规模化 AI 开发和部署等。

系统化

系统性提升用户 AI 工程化能力,提高 AI 计算的自动化水平,为规模化 AI 研究和生产提供加速。

易于扩展

平台功能可不断延伸,支持 AI 技术的长期进化;适配多样化基础设施环境,并支持集群的各种扩展方式。

灵活开放

基于云原生标准构建, 架构先进、开放;提供标准化接口,支持快速集成和被集成,促进协同进化

自主可控

核心功能全部自研,确保产品长期安全可控;致力于推动核心基础设施软件国产化生态的构建与发展。